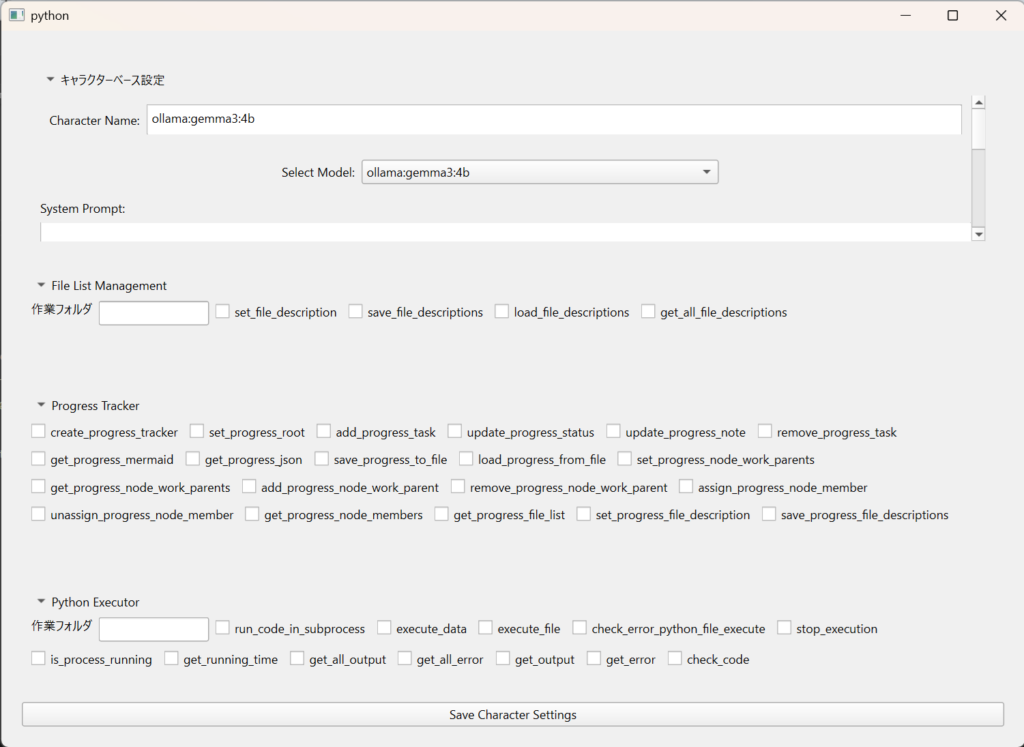

キャラクターエディタの現状。

下のほうのtyっくバックスは指定の書式で書いておくと自動登録されるようにしてある。見栄えを整えたいがそれは後回し。

以前作った記憶のあるコードが見つからないとなんかへこむよね。

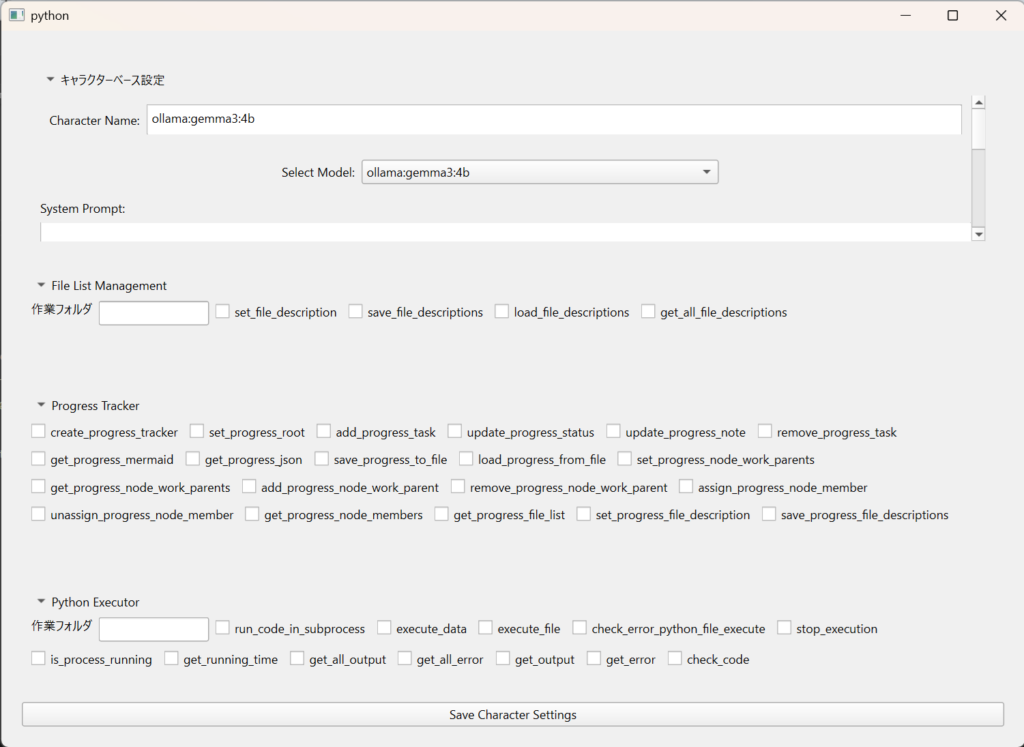

キャラクターエディタの現状。

下のほうのtyっくバックスは指定の書式で書いておくと自動登録されるようにしてある。見栄えを整えたいがそれは後回し。

以前作った記憶のあるコードが見つからないとなんかへこむよね。

LMstudioのバージョンアップが来てて、thinkingが取れなかったのopenai apiの問題を修正とかのってんだけど。

今確認してみたけど、自分の書いたコードに影響は与えなそうなのでよかった。

LMstudio周りの不具合修正完了。表記がopenaiとなっていたため、スレッド切り替え時聖女に読み込めない問題を修正。表記自体をlmstudioと表示されるように修正。thinkingもとれるようにした。

キャラクターエディットに取り掛かる。キャラクターエディットが出来上がったらまとめてアップロード予定。

LMstudioのモデルを使用すると不具合が出てたのだな。thinking をとれないのでOllamaで動作確認していいたから気が付かなかった。キャラクターエディット機能作っているからそれと共に修正を公開かな。

エージェントを作ることを考えると今のllmbaseはほとんど使いまわせないので、llmbaseからいくつかの関数をAICharacterに移動。

エージェント用と通常チャット用で作り分けしないといけないので、AICharacterを分けるかも。

そう追加もしてどうにか動くところまで行った。

今、アプリケーション部分が大きくなりすぎるので、もう一層追加して3層にしようと思う。

core->service->application

とする予定

core 純粋な機能

service coreやseviceを組み合わせたもの。GUIとデータベースの紐づけ。個別動作の実態。

application:serviceをレイアウトしてソフトの外観を作る。

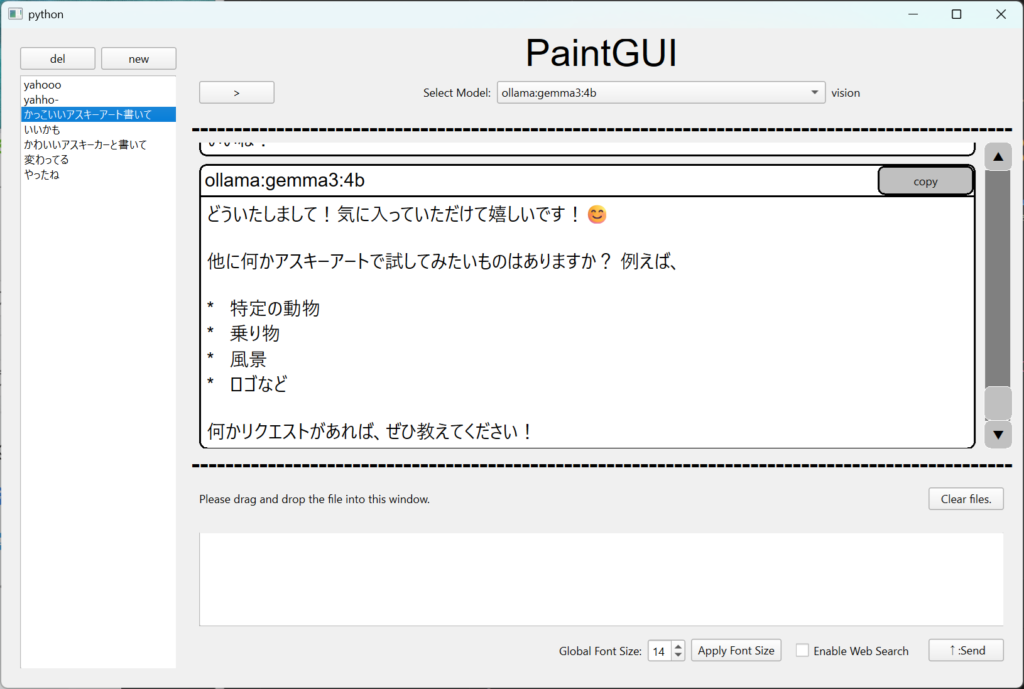

AIChatをアップロードしました。

ダウンロードはできますが、ソースコードのページはまだ更新されてません。

せっかくなのでAIにやらせることができないか、挑戦してみようと思います。

サイトの壊れたらお察しください。

——–

wordpressは単純にFPTでアップロードすればいいわけではないのか

どこで打ち切るかは大切だよね。

langchainがイメージを履歴で保存してくれない。

もともと履歴表示の際に、テキストファイルが履歴に表示されるのに、送信直後は表示されないため、挙動としておかしいのでテキストだけども表示されるようにしようと思っていたのに、いつの間にか「イメージも」、となっていた。

イメージが保存されないのは、あとで対策が必要。履歴表示の際に実際画像が見えていないのは確認済み。

この流れだとワードデータなんかは再現不可になる。

ーーーー

ある程度形になった。いったんこれでアップロードしようかな。AIによるテキスト編集機能を持たせたいけど、それまで入れると、あらにGUI追加で永遠と耕起できなさそうだし。

今の段階でも複数のpythonファイルを与えてアドバイスを受けるとかの使い道があるんだよね。無課金だと長めのコードエラーになったりするから、ローカルで心置きなく長めののコードをドロップして実際使い始めてる。

モデル選択周りの手回し完了。ただまだ細かいところで気になることがあるので、修正が必要。

データ管理ができたのでモデル選択の手直しと、テキストエディット機能を追加でアップロードできるかも。最低限使えるツールになるのではと期待。

なんでわざわざ、チャットソフトを自作しているかというと、このメモリ管理機能がエージェントでどうしても必要になるからというのがある。