抵抗挟んだりしてみたけどうまくいかなかった。

Hブリッジのモジュールを買うことにした。2A出力のDC-DCと2Aまで使えるモジュールを組み合わせることにした。また機材待ち。

腕回りは、Jetson nano で正常に動作するのを確認

抵抗挟んだりしてみたけどうまくいかなかった。

Hブリッジのモジュールを買うことにした。2A出力のDC-DCと2Aまで使えるモジュールを組み合わせることにした。また機材待ち。

腕回りは、Jetson nano で正常に動作するのを確認

抵抗を単純に挟むのはダメだった。800mA以下にするために単純に10オーム挟んだらモータが動かなった。

5オームでどうにか動いたけど遅い。この場合許容電流値をオーバーする可能性がある。

首と腕はどうには動くようになったが足回りは機材待ち。

Hブリッジの機材5個ほぼ全滅。

1個目:なんか調子悪いな別のに変えてみるか。

2個目:あー動いた動いた。…あれなんか今パシュというととともに煙出なかった?

3個目:左右同時に動かすと壊れるのか?

4,5個目:左用右用に分ければいいか。あ、左が壊れた。左側のポートが壊れやすいのか?別のポートで試してみるか。やっぱり壊れた。機材がダメだったかな。右と交換してみるか。バックで壊れるのか?てな感じで5個ほぼ全滅。1ポートだけ生きている状態。抵抗挟まなくてはいけなかったみたいだ。おそらく抵抗挟めば壊れることはなくなるだろうけど、左のモーターの挙動が怪しいのが気になる。

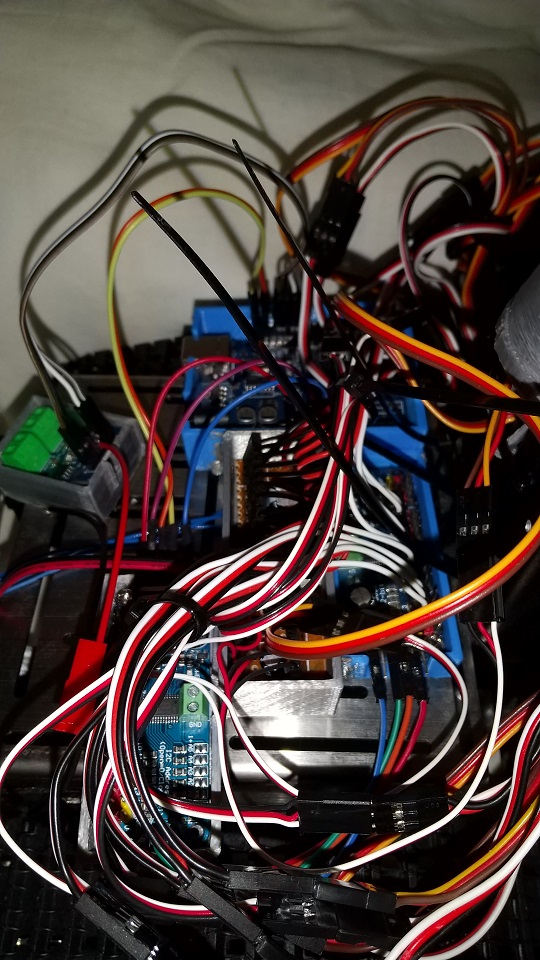

現状でいったんPCでやっていたのをJetsonNanoに移してやってみる。

電気的な要素に問題があったりして、単純なプログラムの問題で片付けられないので、いろいろ確認しながら進めてるため苦戦気味。

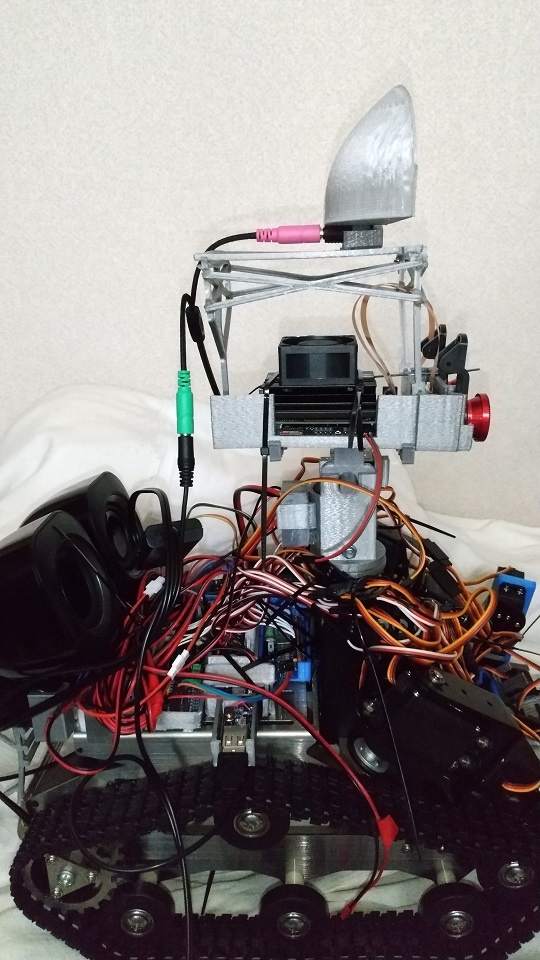

首の更新、マイクスタンド(マイクと耳)、バッテリー台のSTLデータ, FreeCADデータをアップロードしました。かなりの部分がはんだごて溶接することが前提となっています。

首はねじを軸にばねを設定できるようになっています。これで少しは首のサーボの負担を減らせるのではないかと期待しています。

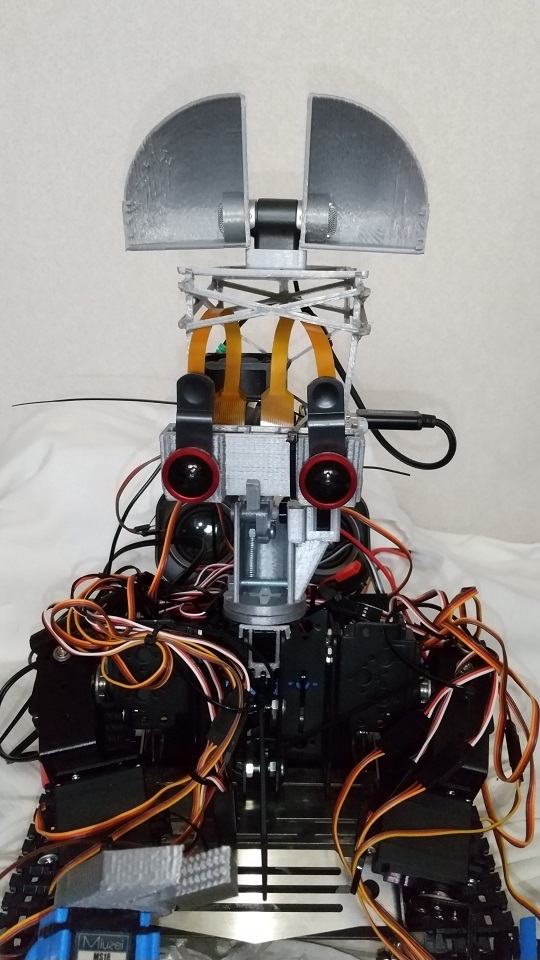

すべての機材を乗せるめどがついた。ここまでのデータをまとめて公開します。

が

こうなりました。写真だとあまり変わらないように見えるけれど、実物での印象はだいぶましになっている。多くの箱をはんだごて溶接で固まりとしてとしている。

足回りとの干渉を減らすために肘の曲がる方向を逆にした。

部品が壊れてしまったので修理も必要。首回りも直す必要がある。気温が上がりきちんとプリントできるか不安だ。

テストプログラムで腕が想定の位置に行ったからおそらく電気的な接続はうまくいった。

電源周り最低限の確認は完了。

若干のプログラムの変更は必要。

新しいPCA9685を出さずとも大丈夫そう。

確認中にケーブルの断線を発見。

など、わずかな間にこまごましたことが色々あった。